Apa itu Peningkatan Gradien?

Gradient Boosting adalah sistem peningkatan pembelajaran mesin, yang merepresentasikan pohon keputusan untuk data yang besar dan kompleks. Itu bergantung pada anggapan bahwa model berikutnya yang mungkin akan meminimalkan kesalahan prediksi kotor jika digabungkan dengan rangkaian model sebelumnya. Pohon keputusan digunakan untuk prediksi terbaik.

Peningkatan gradien juga dikenal sebagai model prediksi statistik. Ini bekerja sangat mirip dengan metode peningkatan lainnya meskipun memungkinkan generalisasi dan optimalisasi fungsi kerugian diferensial. Seseorang menggunakan peningkatan gradien terutama dalam prosedur regresiRegresiRegresi Analisis adalah pendekatan statistik untuk mengevaluasi hubungan antara 1 variabel dependen & 1 atau lebih variabel independen. Ini banyak digunakan dalam sektor investasi & pembiayaan untuk meningkatkan produk & layanan lebih lanjut. baca lebih lanjut dan klasifikasi.

Takeaway kunci

- Peningkatan gradien adalah teknik pembelajaran mesin yang membuat prediksi bekerja lebih sederhana.

- Ini dapat digunakan untuk memecahkan banyak masalah kehidupan sehari-hari. Namun, peningkatan bekerja paling baik dalam serangkaian kendala & dalam serangkaian situasi tertentu.

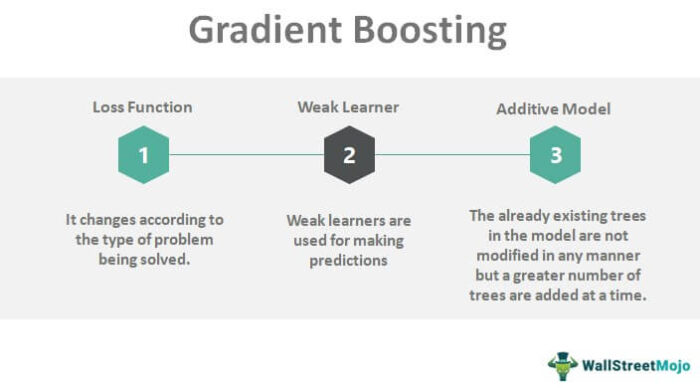

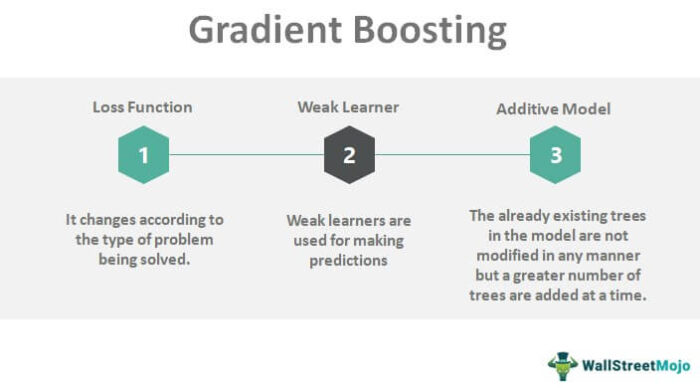

- Tiga elemen utama dari metode boosting ini adalah loss function, weak learner, dan additive model.

- Teknik regularisasi digunakan untuk mengurangi efek overfitting.

- Aspek peningkatan gradien adalah regularisasi melalui penyusutan. Jika tingkat pembelajaran kurang dari 0,1, sangat penting untuk menggeneralisasi model prediksi

Penjelasan

Gradient boosting menciptakan model berbasis prediksi berupa kombinasi model prediksi lemah. Hipotesis lemah adalah parameter yang kinerjanya sedikit lebih baik daripada pilihan yang dibuat secara acak. Leo Breiman, seorang Ahli Statistik Amerika, menafsirkan bahwa peningkatan dapat menjadi algoritme pengoptimalan jika digunakan dengan fungsi biaya yang sesuai. Seseorang melakukan optimalisasi fungsi biaya dengan secara iteratif mengambil hipotesis yang lemah atau fungsi dengan gradien yang relatif negatif. Metode peningkatan gradien telah menyaksikan banyak perkembangan lebih lanjut untuk mengoptimalkan fungsi biaya.

Anda bebas menggunakan gambar ini di situs web Anda, templat, dll., Harap berikan kami tautan atribusiBagaimana Memberikan Atribusi? Tautan Artikel menjadi Hyperlink

Misalnya: Sumber: Gradient Boosting (wallstreetmojo.com)

Bagaimana Peningkatan Gradien Bekerja?

Cara kerja gradient boosting berkisar pada tiga elemen utama. Ini adalah sebagai berikut:

- Fungsi kerugian

- Seorang pembelajar yang lemah

- Model aditif

#1 – Fungsi Kerugian

Tujuan dasar di sini adalah untuk mengoptimalkan fungsi kerugian. Fungsi kerugian berubah dengan berbagai jenis masalah. Seseorang dapat dengan mudah menentukan fungsi kerugian standar mereka sendiri, tetapi harus dapat dibedakan.

Sebagai contoh, kita dapat mengatakan bahwa regresi dapat menggunakan kesalahan kuadrat & klasifikasi dapat menggunakan kerugian algoritmik. Salah satu hal terbaik tentang peningkatan gradien adalah bahwa dengan setiap kerangka kerja, algoritme peningkatan baru tidak diperlukan untuk setiap fungsi kerugian yang dipermasalahkan. Dengan demikian, kerangka kerja yang lebih umum sudah cukup.

#2 – Pelajar Lemah

Pelajar yang lemah adalah untuk tujuan membuat prediksi. Pohon keputusan pada dasarnya adalah pembelajar yang lemah. Pohon regresi khusus digunakan untuk nilai output riil yang digunakan untuk pemisahan. Kami dapat mengoreksi pengingat dalam model prediksi. Skor kemurnian seperti Gini memilih titik pisah terbaik, yang selanjutnya membangun pohon.

Ketika datang ke teknik peningkatan lain yang disebut Adaboost, seseorang menggunakan pohon keputusan tumpahan tunggal. Dalam hal jumlah level yang lebih tinggi (katakanlah 5 sampai 10), kita dapat menggunakan pohon yang lebih besar. Lebih baik membatasi atau membatasi peserta didik yang lemah dalam menggunakan jumlah simpul daun atau jumlah lapisan atau jumlah belahan, atau bahkan jumlah lapisan.

#3 – Model Aditif

Tidak ada modifikasi pohon yang sudah ada sebelumnya dalam model, tetapi ada penambahan jumlah pohon yang lebih banyak sekaligus.

Pada saat penambahan pohon, prosedur penurunan gradien meminimalkan kerugian. Ini meminimalkan jumlah parameter yang ditetapkan. Untuk mengurangi kesalahan, ada pembaruan bobot hanya setelah menghitung kesalahan.

Sub-model pembelajar yang lemah menggantikan parameter. Setelah menghitung kerugian, kita harus menambahkan pohon ke model dengan cara mengurangi kerugian sehingga kita dapat melakukan prosedur penurunan gradien. Pada akhirnya, kita dapat menambahkan output ke urutan pohon.

Contoh Peningkatan Gradien

Mari kita ambil contoh pemain golf yang harus memukul bola untuk mencapai tujuan.

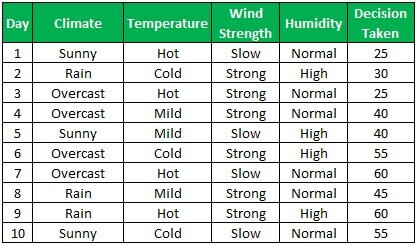

Ini adalah kumpulan data yang tersedia:

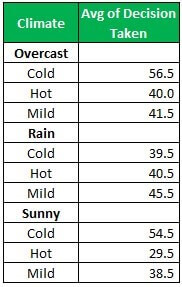

Dengan menggunakan fungsi pivot, kita dapat menemukan keputusan rata-rata untuk setiap kondisi iklim

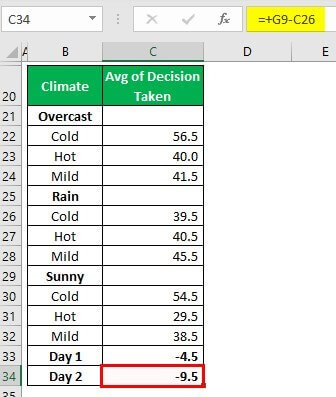

Jadi untuk iklim yang cerah, keputusannya harus 23 (dingin), 25 (panas), dan 52 (ringan). Dari data aktual di atas untuk hari 1 & hari 2, kita dapat mengamati kesalahan berikut

Kami akan menghitung kesalahan di atas untuk semua hari dalam lingkaran dan membuat kumpulan data baru. Kami melakukan ini 4-5 kali untuk menghitung kesalahan. Satu dapat melakukan ini dengan bantuan perangkat lunak otomatis.

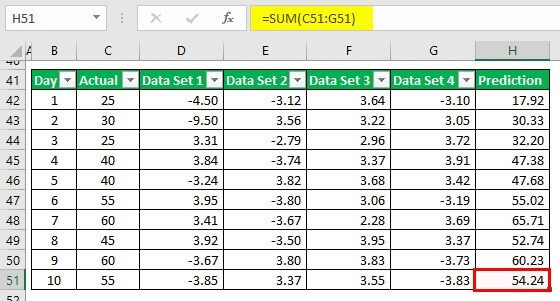

Hasilnya adalah sebagai berikut:

Regularisasi Peningkatan Gradien

Kami menggunakan teknik regularisasi terutama untuk mengurangi efek overfitting. M adalah salah satu parameter regularisasi paling populer. Jadi, M menunjukkan jumlah pohon di seluruh model. Ini juga menghilangkan degradasi setelah penyempitan prosedur pemasangan yang sesuai.

Semakin besar jumlah gradien meningkatkan iterasi, semakin banyak pengurangan kesalahan, tetapi meningkatkan masalah overfitting. Dengan demikian, kita dapat mengatakan bahwa memantau kesalahan sangat penting untuk memilih menggunakan nilai yang optimal.

Kedalaman pohon dalam pohon keputusan dapat menjadi parameter yang efisien untuk regularisasi. Ini dapat dilakukan sebagai tindakan tambahan menggunakan iterasi penguat gradien. Semakin dalam pohon, semakin besar kemungkinan overfitting data pelatihan.

Algoritma Peningkatan Gradien

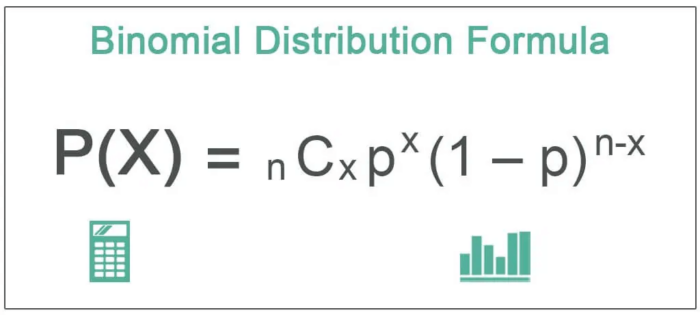

Tujuan algoritme adalah untuk menentukan fungsi kerugian & kemudian mengambil tindakan untuk mengurangi fungsi tersebut. Kita dapat menggunakan MSE, yaitu Mean Squared Error, sebagai fungsi kerugian. Ini didefinisikan sebagai berikut:

RUGI = ∑ (ý – þ)2

Di mana

- Ý = nilai target fungsi

- þ = nilai prediksi fungsi

Kuadrat dari penyimpangan & kemudian penjumlahan dari kuadrat tersebut disebut fungsi kerugian.

Tujuan kami adalah untuk mengurangi fungsi kerugian sedekat mungkin ke nol. Untuk mengurangi fungsi kerugian, kami akan menggunakan penurunan gradien & mengatur pembaruan nilai prediksi. Oleh karena itu, kita perlu mencari tahu di mana MSE paling sedikit. Dengan menggunakan rumus berikut, MSE minimum dapat diturunkan:

Oleh karena itu, tujuan dasarnya adalah untuk mengurangi jumlah residu serendah mungkin.

Penyusutan Peningkatan Gradien

Bagian penting lain dari peningkatan gradien adalah regularisasi melalui penyusutan. Penyusutan mengubah aturan pembaruan. Aturan pembaruan tidak lain adalah tingkat pembelajaran. Telah diamati bahwa jika tingkat pembelajaran kurang dari 0,1, sangat penting untuk menggeneralisasikan model prediksi. Namun, jika laju pemelajaran sama dengan satu, dapat terjadi peningkatan yang signifikan dalam peningkatan gradien meskipun tidak ada penyusutan. Tapi ini meningkatkan waktu komputasi. Jika tingkat pembelajaran rendah, ada persyaratan yang lebih tinggi untuk jumlah iterasi.

Pertanyaan yang Sering Diajukan (FAQ)

Apa itu peningkatan gradien dalam pembelajaran mesin?

Peningkatan gradien adalah metode peningkatan dalam pembelajaran mesin di mana model prediksi dibentuk berdasarkan kombinasi model prediksi yang lebih lemah.

Bagaimana cara kerja peningkatan gradien?

Algoritme peningkatan gradien berisi tiga elemen. Fungsi kerugian berubah sesuai dengan masalah yang dihadapi, pembelajar lemah yang digunakan untuk membuat prediksi, dan model aditif di mana pohon ditambahkan dengan prosedur penurunan gradien. Metode memprediksi kemungkinan model terbaik dengan menggabungkan model berikutnya dengan model sebelumnya, sehingga meminimalkan kesalahan.

Kapan menggunakan peningkatan gradien?

Peningkatan gradien umumnya digunakan untuk mengurangi kemungkinan kesalahan saat memproses data yang besar dan kompleks. Selain itu, ini digunakan untuk membuat prediksi terbaik dalam prosedur regresi dan klasifikasi.

Artikel yang Direkomendasikan

Ini telah menjadi panduan untuk Gradient Boosting & Definisinya. Di sini kita membahas regularisasi peningkatan gradien, cara kerjanya, contoh, penyusutan & algoritma. Anda juga dapat melihat artikel berikut untuk mempelajari lebih lanjut –

- Regresi Nonlinier

- Regresi Kuadrat Terkecil

- Pemodelan Stokastik